深谷技术 | 基于FoundationPose模型的6D姿态检测方法

发布日期:2025-12-08 浏览次数:48

6D姿态检测(6D Pose Estimation)旨在通过输入物体的各方位图像、点云数据或CAD模型文件,精确预测目标物体在三维空间中的旋转(3D旋转矩阵)和平移(3D位置向量),即6个自由度(6D)。该技术在机器人抓取作业、增强现实(Augmented Reality)、自动驾驶等领域具有重要作用。例如在工业场景中,机械臂需通过6D姿态估测实时定位零件位置以完成机械组件的装配;在AR应用相关场景中,虚拟的物件需与真实的物体场景精确对齐以增强沉浸感。

实际开发和应用中6D姿态检测在复杂背景、跨域适应性和实时性的方面提出了更高的要求,2024深度视觉会议CVPR的较高分论文《FoundationPose: Unified 6D Pose Estimation and Tracking of Novel Objects》提出了FoundationPose模型以物体的RGBD图或CAD模型作为模型输入,输出实时预测的姿态信息或者使用跟踪算法计算物体姿态检测的信息。

图1 FoundationPose模型的物件信息输入和姿态检测输出模式图

在模型预训练过程中,FoundationPose基于大语言模型LLM-ChatGPT和扩散模型通过文字化的prompt信息引导LLM生成指定的物体3D模型纹理和外观,基于 LLM 生成的物体文本描述,在NVIDIA Isaac Sim仿真环境中生成带随机纹理、材质、相机视角和照明条件的3D物体图像数据,物件的纹理、材质、相机位置和照明参数随机设置,以生成合成后的模型数据。

图2 大语言模型辅助的合成数据生成

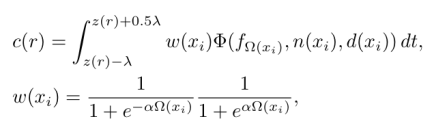

在通过物件的RGBD图像模式作为训练输入的情况下,FoundationPose通过神经隐式场表示来进行较为高效的物体建模。神经隐式场表示包括场表示、场学习和渲染的主要步骤。其中场表示为SDF方法采用公式为:

对于纹理学习采用取近表面区域的体渲染表示为:

对于几何学习采用混合SDF模型以分别学习SDF,通过程函正规化应用于近表面SDF:

训练后的神经隐式场可以作为传统图像流水线的进行高效渲染的迭代模型,在原先NeRF基础上需要基于RGBD的姿态估计和追踪的深度渲染。物件建模后生成多个假设的姿态的步骤包括,姿态初始化和姿态细化。现有方法如Mask R-CNN或CNOS用于物件的检测,在探测到的2D边框采用中等深度的3D点位进行转换的初始化。

图3 神经隐式场建模和假说姿态生成

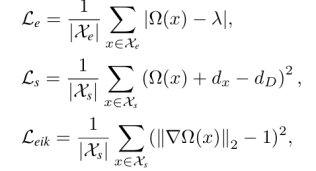

在姿态细化的方面,投影初始物件至图像空间以确定图像剪辑的方位,基于CNN编码器的模型用于提取RGBD输入分支的特征向量,经分别处理的transformer编码器网络预测转换和旋转至输出维度。初始的输入向量的更新公式为:

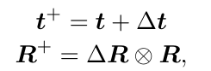

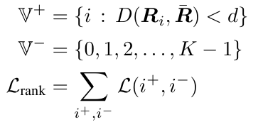

初步生成后的姿态经过包括层次化比较和对比验证的姿态识别选择以选出最准确的姿态。在验证阶段只保留其正样本是与基准值足够接近的姿态对以让对比有效:

经过两级比较可以确定每个姿态的得分进而选择得分最高的姿态作为最终结果。基于假设姿态的全局上下文通过多头自注意力机制实现,处理拼接后的所有特征嵌入,考虑到假说姿态的相对差异选择识别的姿态。

图4 假说姿态的两级选择模型

在LINEMOD数据集中,测试的姿态检测估计效果为:

表1 姿态估计结果在LINEMOD数据集上的数值统计

基于CAD模型的位姿估计效果,通过代表性BO数据集上的AR分数进行测量:

表2 由AR分数在BOP数据集中的姿态估测效果

YCBInEOAT数据集中测试的RGBD方法的姿态追踪效果:

表3 在YCBInEOAT数据集中由AUC测量的RGBD方法的姿态追踪效果

姿态估测和追踪的实际效果图像为:

图5 实际物件的姿态估计和相机追踪的效果图像

在基于FoundationPose模型的6D姿态检测方法的例化中,基于神经隐式场的物件建模和基于LLM的合成大规模数据建模方法较为创新地生成了训练数据并进行假说姿态的生成和识别姿态的选型,支持单模态(RGBD 图像 / CAD 模型)输入和多模态融合输入,适配不同场景。开发者可根据应用场景例化相应的算法模型,并结合数据增强、轻量化部署等策略优化模型性能。随着三维视觉技术的演进,基于FoundationPose模型的6D姿态检测将应用在更多的应用场景。

[参考资料]

[1] Bowen Wen, Wei Yang, Jan Kautz and Stan Birchfield. FoundationPose: Unified 6D Pose Estimation and Tracking of Novel Objects, CVPR, 2024.